Algorithmen können Autos lenken, Verbrecher überführen, Bankgeschäfte prüfen - und manchmal ziemlich plump daher kommen. Die Geschichten dazu sind so zahlreich wie schmerzlich: Ein Algorithmus, der Amazon bei der Bewerberauswahl unterstützen sollte, schlug vor allem Männer vor, die Google-Bilderkennung verwechselte schwarze Menschen mit Gorillas und forderte asiatisch Aussehende Menschen dazu auf, die Augen zu öffnen. Und bei YouTube wurden zum Großbrand von Notre-Dame Videos des 9/11-Terroranschlags aus New York zugeordnet. Einfach ein schlechter Algorithmus?

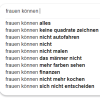

Die Kritik an Algorithmen haben jüngst auch die Frauen- und Gleichstellungsministerinnen der Länder aufgegriffen. Sie stören sich besonders an der Auto-Vervollständigung bei Suchmaschinen. Wer in das Suchfeld der Microsoft-Suchmaschine Bund "Frauen können" tippt, bekommt an erster Stelle vorgeschlagen, den Satz mit "nicht Auto fahren" zu ergänzen. Die Bundesregierung soll nun prüfen, ob den Algorithmen "Diskriminierungsmechanismen" zugrunde liegen.

Können Algorithmen diskriminieren?

Diesen Ansatz findet Lorena Jaume-Palasí falsch. Sie ist Gründerin der Ethical Tech Society in Berlin, die sich mit der sozialen Dimension von Technologie beschäftigt. "Die Ursache von Diskriminierung sind immer Menschen", sagt Jaume-Palasí derDeutschen Presse-Agentur. "Anstelle des Regulierens der Ursachen, die Diskriminierung verursachen, fokussiert man sich auf die Technologie, die menschliches Diskriminierungsverhalten widerspiegelt."

Um Jaume-Palasís Kritik zu verstehen, muss man Algorithmen verstehen. Ein Algorithmus sind Anweisungen zur Lösung eines bestimmten Problems - wie ein Rezept. Er definiert, wie ein bestimmter Vorgang ausgeführt werden soll. Künstliche Intelligenz (KI) basiert auf Algorithmen. Dabei wird intelligentes Verhalten nachgebildet. Die Maschine soll informierte Entscheidungen treffen. Damit sie das kann, wird sie mit Datensätzen gefüttert. Die Technologie erkennt Zusammenhänge und kann fortan, basierend auf diesem Hintergrundwissen, zum Beispiel Entscheidungsempfehlungen geben.

Das liefert eine Erklärung für die voreingenommenen Ergebnisse, etwa bei der Suche nach geeignetem Personal: "In der Vergangenheit gab es in Unternehmen die Einstellungspraxis, dass vermehrt weiße Männer eingestellt wurden", sagt Susanne Dehmel vom Digital-Verband Bitkom. Trainiere man den Algorithmus mit diesen historischen Daten, suche er die Kandidaten eben auch entsprechend aus. Auch bei der Gesichtserkennung, die schwarze und asiatisch aussehende Menschen diskriminierte, liegt die Vermutung nahe, dass das Problem nicht beim Algorithmus liegt. Fragwürdig war wohl vielmehr die Auswahl der Bilder, mit der die Maschine trainiert wurde.

Technologien halten der Gesellschaft einen Spiegel vor

Dem Anspruch, Probleme wie oder besser als Menschen zu lösen, wird künstliche Intelligenz in vielen Fällen also noch nicht gerecht. Dehmel kann den Ergebnissen etwas Positives abgewinnen: Die Technologien hielten der Gesellschaft einen Spiegel vor, und zeigten, wie akut Diskriminierung noch sei. Suchmaschinenanbietern nun einen erzieherischen Auftrag zu erteilen, möglichst diskriminierungsfreie Inhalte auszuspucken, findet Dehmel falsch. Sie filterten nach Relevanz, Ergebnisse ergäben sich aus dem, was Leute anklicken. "Die Anforderung würde die Funktion überfrachten."

Dass Google durchaus in die Präsentation der Ergebnisse eingreift, zeigen verschiedene Beispiele, etwa das der US-amerikanischen Professorin Safiya Umoja Noble. In ihrem 2018 erschienenen Buch "Algorithms of Oppression" kritisierte sie unter anderem rassistische und stereotype Vorschläge für die Autovervollständigung des englischen Satzes "Warum sind schwarze Frauen so". Wer heute den Satz in die Suchmaschine tippt, bekommt keine Ergänzungen mehr vorgeschlagen.

Große Aufmerksamkeit erfuhr in Deutschland 2015 auch der Streit zwischen Bettina Wulff und Google über die Kombination ihres Namens mit ehrabschneidenden Begriffen in der Autocomplete-Funktion. Der Konzern lenkte ein und entfernte die Ergänzungen zur Frau des damaligen Bundespräsidenten. Unabhängig davon hat Google im Juni 2018 angekündigt, künftig ein besonderes Augenmerk darauf zu legen, dass Software keine "unfairen Vorurteile" aufweist oder nach Hautfarbe, Geschlecht, sexueller Orientierung oder Einkommen diskriminiert.

Künsliche Intelligenz geht nicht nur Informatiker etwas an

Eine, die die Dinge selbst in die Hand nehmen wollte, ist Johanna Burai. Die Designerin aus Schweden hat sich an Suchergebnissen bei der Recherche nach Fotos von Händen gestört.

Doch wie kann sichergestellt werden, dass auch KI-Technologien künftig klügere und fairere Entscheidungen treffen? Rechtlichen Handlungsbedarf sieht Expertin Dehmel nicht. "Es ist ein Kompetenzproblem. Erst wenn man versteht, wie die Technologie funktioniert, kann man auch Diskriminierung sorgfältig entgegentreten", meint Dehmel. Dass es nicht ausreicht, Angaben zu Gender und Hautfarbe aus den Datensätzen zu nehmen, haben Beispiele aus der Vergangenheit gezeigt. Algorithmen fanden Stellvertreter-Variabeln in den historischen Daten und kamen so zu den gleichen diskriminierenden Ergebnissen. Dehmel schlägt darum diverse Datensätze, eine sorgfältige Konzeption der Trainings sowie Testläufe vor.

Jaume-Palasí fordert vor allem kontinuierliche Kontrolle der algorithmischen Systeme. Hinter KI müsse mehr als ein Entwickler und ein Datenwissenschaftler stehen. Für die Kontrolle "braucht man Soziologen, Anthropologen, Ethnologen, Politologen. Leute, die die Ergebnisse in dem jeweiligen Sektor, in dem die Technologie angewendet wird, besser kontextualisieren können", sagt die Datenethikerin. "Wir müssen endlich abkommen von dem Glauben, dass KI ein informatisches Thema ist. Es sind soziotechnische Systeme und die Berufsprofile, die wir da brauchen, sind wesentlich vielfältiger." (dpa)

Wir wollen wissen, was Sie denken: Die Augsburger Allgemeine arbeitet daher mit dem Meinungsforschungsinstitut Civey zusammen. Was es mit den repräsentativen Umfragen auf sich hat und warum Sie sich registrieren sollten, lesen Sie hier .